一、 起因:虚假的繁荣

事情始于 10 月份。我的网站访问量突然飙升,成倍暴涨。

对于任何站长来说,这本该是高兴的时刻。但当我深入服务器日志和统计后台时,心却凉了半截——这根本不是自然的增长,而是一场灾难。

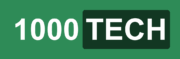

Google Console 页面收录也超过了几十万:

二、 问题:流量背后的四个“大坑”

这一波暴涨的流量,不仅没有带来收益,反而可能带来了灾难:

- Bot 泛滥成灾 原本应该由真实用户产生的 PV,现在全被机器占领了。日志里全是 GPTBot、AmazonBot、ClaudeBot 等 AI 模型的爬虫,还有大量不知名的恶意采集脚本。它们消耗了服务器资源,却不产生任何价值。

74.7.242.10 - 104.22.1.96 - - [02/Dec/2025:03:45:13 -0500] "GET /de/calculators/reverse_sales_tax/1.92_63306_reverse_sales_tax HTTP/1.1" 200 44726 "-" "Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.3; +https://openai.com/gptbot)" "74.7.242.10" "US" "0.176" "0.177" - AdSense RPM 下跌 流量分母变大了,但分子(有效点击)没变,甚至因为 Bot 的误触和无效展示,导致页面 RPM(每千次展示收入)直接崩盘。本来 RPM 还有1~2 刀,现在直接掉到了 0.01 刀。

- 账号安全亮红灯 这是最让我焦虑的。大量垃圾流量涌入,极易被 Google 判定为“无效流量(Invalid Traffic)”。一旦触碰红线,轻则扣除收益,重则直接封禁 AdSense 账号,多年的心血可能毁于一旦。

- 站点信任度崩塌 大量低质量的 Bot 访问会导致跳出率异常、页面加载变慢。在搜索引擎眼中,这可能被视为站点质量下降的信号,进而影响 SEO 排名。

三、 解决:构建四层防御体系

这种情况下,再等这个站就要废了。我采取了以下“组合拳”进行清洗和重建:

- 第一道防线:Robots.txt (君子协定)

虽然对流氓爬虫无效,但对正规军(如 GPT、Claude)还是有用的。我更新了 robots.txt,明确禁止 AI 爬虫抓取内容,表明态度。

- 第二道防线:Cloudflare WAF (守护门神)

这是最有效的一招。

- 封禁 Bot: 直接利用 Cloudflare 的规则库,拦截那些 AI 爬虫;

制定规则:判断 UserAgent 包含 bot,下一步动作选 Block(阻止)。 - 人机验证 (Managed Challenge): 对于那些特征模糊、无法直接判定为 Bot 的可疑流量,不再直接放行,而是弹出一个“验证码”挑战。真人点一下就能过,脚本通常会被卡死。

制定规则:判断 URI 路径中,包含某个特定的页面,下一步动作选托管咨询。

- 第三道防线:Nginx 服务端拦截 (最后兜底)

对于穿透了 CDN 的请求,我在 Nginx 层面做了配置。针对那些请求路径异常、包含恶意参数的 URL,直接返回 401 Unauthorized 或 403 Forbidden,从源头切断资源消耗。

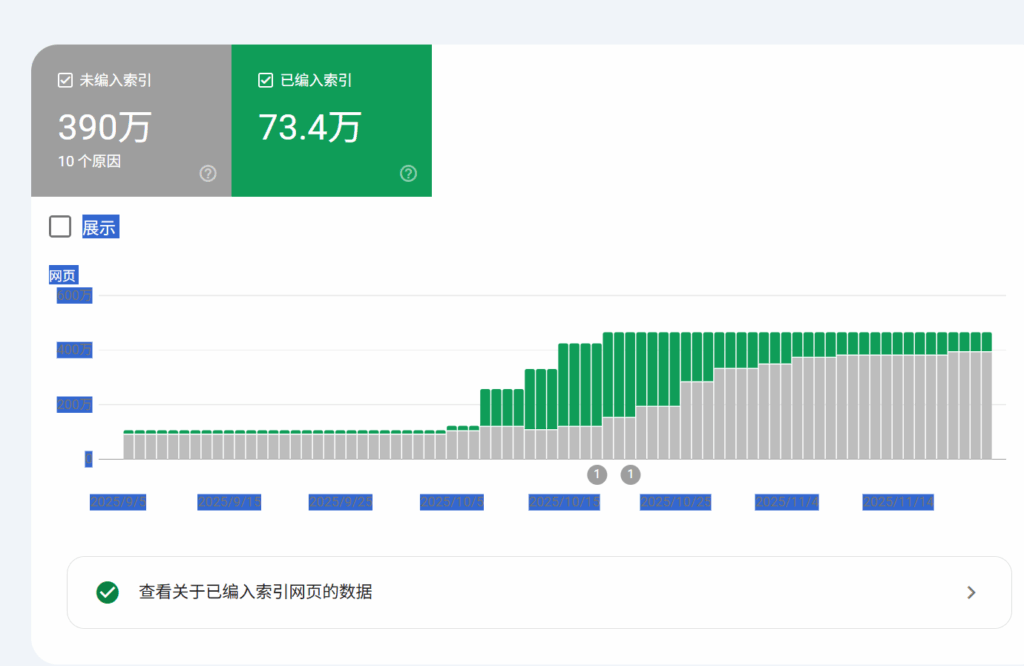

- 第四道防线:Google Search Console (清理门户)

流量暴涨期间,很多低质量构造的页面被 Google 索引了。我不得不手动在 GSC 中提交删除请求。这是一个漫长的过程,可能需要半年甚至更久,站点的权重和各项指标才能慢慢恢复到正常水准。

四、 遗留问题

在实战中,还有两个关键的技术难点需要特别注意:

- Cloudflare 的规则是否会误杀 Google Bot?

这是一个必须极其小心的问题。

- 策略: 在配置 Cloudflare WAF 规则时,必须将 “Known Bots” (已知良性爬虫) 设为白名单或者“跳过(Skip)”。

- 原理: Cloudflare 会验证 Googlebot 的 ASN 和反向 DNS,确保它是真的 Google 爬虫,而不是伪装的。只要配置得当,不仅不会影响 SEO 抓取,反而能让 Google 抓取到更纯净的内容。

- 如何识别“伪装请求”?

很多高级爬虫会伪造 User-Agent 为 Chrome 浏览器,甚至使用住宅 IP 代理。仅靠 UA 识别已经过时了,我的判定逻辑升级为:

- 验证 User-Agent:某些用户代理伪装得太明显了,比如其中的 Chrome 版本居然是。142.0.0.0,用户的 Chrome 浏览器基本上很少有这种整齐的版本号;

- 验证 Url:典型的非用户请求 url:

https://xxxx.com/167772.16_651_reverse_sales_tax,正常的人类不可能使用这种数据(167772.16_651),基本是构造出来的 url; - 验证 Referer: 检查请求来源是否合理(例如是否来自空 Referer 的深层页面访问)。

- IP 行为分析: 同一 IP 短时间内的高频访问、遍历式扫描。

五、 总结与展望

当我们发现站点访问量存在异常情况时:

- 立即行动:不要抱有幻想,必须立刻介入,否则后续更难修正,比如加入 Google 索引页面都已经超73万,这种站点很可能被 Google 判定为垃圾站。

- 慢慢恢复:在确认流量清洗干净、Bot 被有效遏制后,才能小心翼翼地重新开启 AdSense 的自动化广告。

现在,虽然流量多了,但每一分流量都是真实的,这样可以有效保证 Adsense 账号的安全。